中国IDC圈6月4日报道:您的数据中心正在使用怎样的冷却策略?您的数据中心是不是总有几台精密空调在永不停息运转,将冷空气吹到机房静电地板下的空间里,再从多孔地板送入一个又一个机柜,通过这种方式来努力维持机房温度?如果是这样的话,您很可能正在浪费大量的电能,那也是大笔的金钱。现在有几种新的冷却方法和技术能提供较好的短期投资回报,还能为公司带来持续的财务收益。

首先,请确认您的数据中心是否把运行温度设置了得太低了。美国采暖、制冷和空调工程师协会(ASHRAE)自2004年起一直在跟踪研究常见类型的数据中心建议温度和容许温度。

数据中心温度的高极限在2004年被设定为77华氏度(25摄氏度) 到2008年,这个温度极限被提升到81华氏度(27摄氏度)。到2011年,ASHRAE建立了一系列数据中心模型,虽然建议的温度维持不变,仍然是81华氏度(27摄氏度),但是高容许温度被提升到113华氏度(45摄氏度)——超过此温度则会观察到设备故障率明显上升。和防范设备故障风险相对应的是,较高温度的数据中心的冷却需求低得多,使用的精密空调(CRAC)机组更少,能耗也得到降低。

最简单的省钱途径就是:减少CRAC精密空调机组开机运行的数量。如果只有一半的制冷量是必要的,关掉另一半精密空调机组将直接节约不少电费——还有对应的机组维护成本。 使用可变速的而不是恒速的精密空调机组也能达到类似的省钱效果,这些空调自动降速,仅运转在维持设定温度必要的速度上,避免无谓的空转。空调机组只有在100%满载时的能源效率高,所以,一些变速机组在低速运行时,并没有运行在用电效率高的负载点,还有优化的余地。

根据以上思路,使用标准、固定功率的精密空调机组,建立“热惯性”冷却系统更划算。在这种冷却方案下,数据中心先被强力冷却到低于需要的温度,空调单元停机待命,让数据中心温度自行缓慢上升,当温度上升到设定的上限时,精密空调单元重新启动运转,开始新一轮制冷循环。通过这种运行方式,机组在每个周期都运行在效率高、最经济的满载状态。 当然,机组关闭周期会有无限大的能源效率比——因为根本就没耗电。

然而,如果对空气冷却和流动的全过程不进行仔细分析,直接就根据建筑容积来设计数据中心制冷方案,其结果必然会造成浪费:大多数被冷却的空气都无法和IT设备足够接近,也就不能对这些设备进行有效冷却。

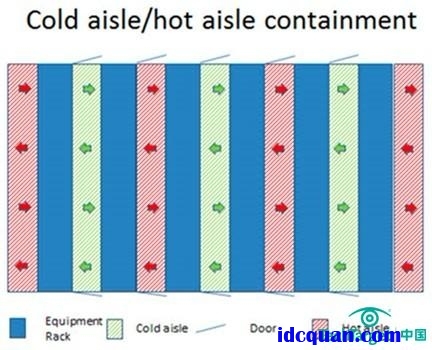

图1:冷/热通道

前面我们将了如何让数据中心增效又省钱,比如有效运用热通道和冷通道,能在维持设定温度的同时减少冷空气的用量,。

机架面对面排列,将两排机架前门之间的通道两头使用门、顶部使用盖板围成全封闭空间。冷空气被吹入这个密闭的空间,从最近的距离进入机架。为了防止冷空气从机架内的设备空隙泄漏,设备之间的空隙可使用盲板填充。部分最热的部件可使用风管引导冷风直接进行降温。

机架后部排出的热空气进入数据中心,然后被排到室外,甚至可以集中用于给其它区域升温。热空气也可以被热泵利用,生产热水。这些系统既可以高度工程化,也能用土办法来实现——使用塑料板自己制作盖板和侧门,很容易就能搞出机架前面的封闭空间。

我们的目标是使每个机架都成为完整的系统,包括冷却的方案,所以冷却空气的用量将被继续精简,制冷设施将更精密和更有针对性。这就催生了Chatsworth Towers这种东西。这些成套系统内部有一个19英寸机架,但是冷却空气从机架底部进入,流通到机架顶部排出,整个过程和数据中心的空气保持隔离。

在某些气候条件下,数据中心如果选择较高的运行温度,则有可能允许采用自然空气冷却,根本不需要精密空调机组。例如,如果数据中心运行温度选择为86华氏度(30摄氏度),低于77华氏度(25摄氏度)的外界空气就已经足够为设备提供冷却了,不需要其它冷却措施——只要空气湿度在合适的范围内就行。

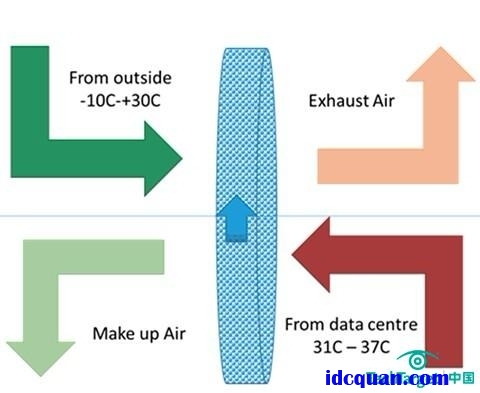

图2:Kyoto Wheel制冷原理

然而,简单地将外部空气使用管道引入数据中心并不可行,例如温度较高的热岛区无法通过自然风有效地冷却,室外空气中的灰尘与污染物进入数据中心会造成设备损坏。于是,新的冷却系统设计,例如类似Kyoto Wheel的产品和解决方案开始发挥作用了。

在这个方案里,一个直径大约3米的热交换器金属盘隔离两个温度区域,并缓慢旋转。数据中心内部的热空气吹过圆盘一侧,将热量传递给圆盘的金属材料。外界的冷空气流经圆盘的另一侧,将圆盘上的热量带走排到外部空气。从数据中心来的热空气被冷却后回到数据中心给设备降温。

数据中心的空气循环是封闭的,圆盘同时也是数据中心和外部空气环境的过滤器,只有极少量的空气会在圆盘旋转过程中泄漏,这样就限制了粉尘或者水汽进入数据中心。

这个方案的好处是,Kyoto冷却系统使用低速的风扇和马达,很少需要维护,电力需求也极少,通常使用太阳能电池和蓄电池就能维持整个系统的运行。这样的系统可以持续使用很多年——预计最低寿命25年——维护工作量仅包括每隔几个月的转盘快速清洗,以及通常的马达检修。

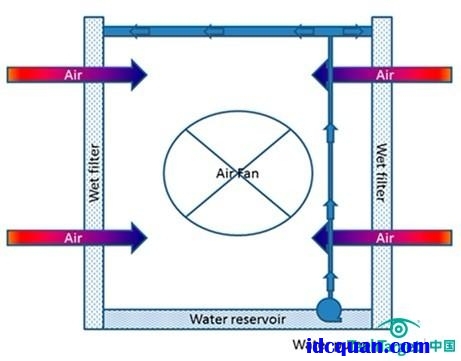

图3:水冷原理

除了前面这些基于空气冷却的方案,另一种方案是,利用水蒸发时的冷却效应构筑绝热冷却系统,参见《数据中心冷却策略:利用空气来保持低温》。

水冷方案在气温较高的地方仍然有效,较高的环境温度正好能用来蒸发冷却器表面的水分,空气流经冷却器时被降温。冷却器将外部空气和数据中心内部隔断,形成2个不同空气区域的冷却系统。 然而,冷却器在室外运作,必须定期清理污物。另外,空气湿度需要予以控制,以免IT设备产生冷凝结露现象而损坏。

对于那些使用极高密度设备,地理上也属于高温区域的公司来说,直接水冷方案是一个解决问题的办法。IBM在很早就用过水冷,但在他们的Aquasar和LiebnizSuperMUC超级计算机系统中,水冷方案被增强到极致。这套系统解决了在数据中心混合使用水和电器的主要隐患:漏水。系统使用负压来吸水,而不是使用水泵压水。因此,如果有管道破裂,也仅仅是让空气泄漏进入冷却系统,而不是让水泄漏出来进入数据中心。先进的传感器元件用来快速识别发生泄露的部位,模块化的架构使得维修不会影响系统其它区域的正常运行。

该系统使用热水作为冷却液,这看起来可能很奇怪。但是在这类特殊系统内,超过86华氏度(30摄氏度)的水仍然可以将CPU部件冷却到工作温度;完成冷却循环后,系统出水温度会接近113华氏度(45摄氏度)。较高温度的水联合热交换器可以为建筑的其它部位生产需要的热水。除了可以将直接能耗降低大约40%,这个系统还能长期节约建筑其它部位的热水生产相关的能源消耗。

给硬件泡澡为了实现更彻底的液体冷却,有的系统使用“液体浸泡式”冷却方案。类似Iceotope和Green Revolution Cooling这样的公司提供的系统会将整个服务器——或者其它类似的IT设施——浸泡在不导电但是具备高导热系数的冷却液中,让冷却液有效地带走设备上所有元件产生的热量。 这些液冷系统非常适合具备数百个核心的高密度GPU服务器,或者具备高密度CPU的超级计算系统。这些冷却系统每个单元涉及的冷却需求可以超过100kw,每个系统基本上都是紧贴机架侧面的密闭结构。某些沉浸式冷却系统的冷却液温度会达到140华氏度(60摄氏度)的高温。

在沉浸式冷却系统中不再需要风扇组件,这也节省了相关的能耗。 由于专用冷却液的吸热性能比空气或者水都要优秀得多,硬件设备可以在更高一些的温度运行,这样也能让冷却液传导出的热量得到更有效的回收和提供给建筑物内需要供热的区域。

完成数据中心冷却,然后呢?

前面论述了几种不同的技术原理的冷却系统,分别应用于不同需求的实际环境。但是,建设冷却系统是短期项目,监控数据中心运行的热量流动情况才是长期任务。这也是数据中心基础设施管理系统的(DCIM)用武之地。使用温度传感器和红外探测器可以建立出数据中心的热点分布图。 计算流体动力学可以用来分析新的冷却过程,验证不同的冷媒初始温度怎样用于不同的系统。

一旦DCIM就绪,持续的冷却效果监控就开始进行,热岛会被快速发现和定位,以便进行后续处理,例如降低负载设备的运行速率、关闭部分过热负载,必要时更换过热设备。在许多情况下,热点分布数据中突然冒出来的热点预示着:该处的设备即将发生故障。 能在故障发生前及早筛查和处理,意味着系统连续运行时间和可用性可以保持在很高的水平。

全世界有无数的数据中心,变革一直在发生,固守旧的冷却观念,结果必定是劳民伤财。 积极采用新的指导原则和新的方法才能实现更有效的冷却,也能达到更低的投资和运维成本。